[25'ODCC成果]KV Cache关键技术研究

当大模型参数规模突破万亿级,实时推理响应速度进入毫秒级竞赛,一个曾被忽略的环节正成为智算技术突破的核心瓶颈——KV Cache的存储效能。在人工智能向产业深度渗透的今天,大模型推理对 KV Cache 的容量、速度与稳定性提出了前所未有的要求。基于此,ODCC存储技术特设组编制了《KV Cache关键技术研究》白皮书。

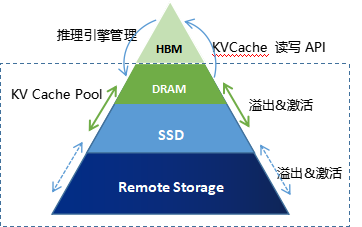

白皮书综合存储缓存介质,网络传输,软件栈及算法,性能收益测评等新型技术,对KV Cache中和存储相关的技术挑战展开分析,结合工业实践和人工智能发展趋势提出存储产业促进智算技术发展倡议。未来,KV Cache技术将深度融合存储硬件创新、网络传输创新与分布式架构,形成“多级缓存+统一内存语义+智能调度”的技术矩阵,成为突破AI推理算力墙的核心支柱。

1.KV Cache技术研究背景

KV Cache是推理算力提升的代表性技术。传统推理框架(如TensorFlow Serving)采用静态计算图模式,存在内存占用高、实时性差等缺陷。随着Transformer架构的爆发式应用,自回归推理成为主流,PD分离(Prefill-Decode Disaggregation) 是优化自回归生成架构的大语言模型(LLM)推理流程而诞生的关键技术,旨在将推理过程拆分为预填充(Prefill)和解码(Decode)两个独立阶段,以提高资源利用率和降低推理延迟。

2.KV Cache和存储相关的关键技术挑战

目前相关技术成熟度较弱,从缓存介质、网络传输协议、接口软件栈、软件算法生态、测试工具和验收标准等诸多方面均需加强,对产业链各环节提出了更密切的协作需求。

▶ KV Cache在新存储介质上优化度方面问题突出

▶ 网络协议传输效率不高,RDMA协议在内存池化中的问题、CXL面临的挑战

▶ 推理框架接口耦合,接口无统一标准

▶ 软件及算法生态不完善

▶ 测试工具和验收标准不统一

3.KV Cache和存储相关发展倡议

结合大模型推理业务发展诉求,提出KV Cache多级缓存的技术发展建议,与存储业界共进,加速智算存储产业化进程。提出五大发展建议:

▶ 协同先进存储介质技术,实现不同方案相结合

▶ 优化网络传输架构,保障网络传输优势和演进能力,如,全光互联、GDS

▶ 接口协议统一设计,缩短适配研发周期,KV接口实现纳秒级索引

▶ 构建开发生态与协议框架,加速规模发展

▶ 测试收益标准化,推动认证标准演进

本成果将于今年9月的开放数据中心大会上正式发布!敬请期待!

郭伟

中兴通讯智算产品规划总工

ODCC存储技术特设组联系人

高老师:17614721889(微信同号) 邮箱:gaowei1@caict.ac.cn

ODCC秘书处联系人

刘老师 13488889649(微信同号) 邮箱:liupengyun@caict.ac.cn