ODCC | 超节点:重新定义 AI 算力的未来引擎

在人工智能加速渗透千行百业的今天,大模型的爆发式增长正推动算力需求进入新纪元。当 ChatGPT、Claude 等 AI 模型的参数量从百亿级跃升至千亿级,甚至万亿级时,传统的算力架构开始显得力不从心。在这个关键时刻,一种名为 "超节点" 的创新技术架构应运而生,正在重新定义 AI 算力的未来。

一、超节点的诞生背景

1.1 算力需求的指数级增长

大模型时代的算力挑战

随着 AI 技术的飞速发展,大模型的参数量呈现出指数级增长的趋势。从早期的 BERT(3.4 亿参数)到 GPT-3(1750 亿参数),再到如今的 GPT-4(1.8 万亿参数),模型规模的爆炸式增长对算力提出了前所未有的要求。

训练一个千亿参数的大模型需要:

1. 数千张高端 GPU/TPU

2. 数十 PB 的训练数据

3. 数百 TB 的模型参数存储

4. 数周甚至数月的训练时间

传统架构的局限性

传统的数据中心架构在面对这种级别的算力需求时,暴露出了明显的局限性:

通信瓶颈:

大模型训练需要海量数据在节点间传输,传统网络的时延和带宽限制成为了性能瓶颈。数据从 A 服务器的 GPU 传到 B 服务器的 GPU,要经过 "GPU→服务器主板→网卡→交换机→网卡→服务器主板→GPU" 多个环节,延迟通常在几十到几百微秒。

资源利用率低:

传统架构无法根据模型特征动态分配资源,导致 "冷热不均" 现象。数据显示,传统集群因通信延迟导致 40% 的计算资源处于空闲状态。

能耗过高:

数据中心年耗电量已占全社会用电量的 2% 以上,传统架构的能效比亟待提升。训练一个大模型的能耗相当于一个小城市的年用电量。

1.2 技术演进的必然结果

从单体服务器到集群计算

算力架构的演进经历了几个重要阶段:

1. 单体服务器时代(1990s-2000s):单台服务器独立工作,算力有限

2. 集群计算时代(2000s-2010s):多台服务器通过网络连接,实现分布式计算

3. 超算中心时代(2010s-2020s):大规模集群,专用高速互联网络

4. 超节点时代(2020s-):高密度整合,统一内存空间,超低延迟互联

摩尔定律的放缓

随着半导体工艺逼近物理极限,单芯片性能提升速度放缓。根据摩尔定律,芯片性能每 18-24 个月翻一番,但近年来这一速度已经明显下降。在这种情况下,通过架构创新来提升整体性能成为必然选择。

AI 算法的特殊需求

大模型训练具有独特的技术需求:

1. 数据并行:将数据分割到不同设备

2. 模型并行:将模型分割到不同设备

3. 流水线并行:将计算流程分割到不同设备

4. 混合专家模型:动态激活不同的计算单元

这些需求对算力架构提出了更高的要求,传统的集群架构难以满足。

1.3 产业竞争的推动

英伟达的引领作用

英伟达最早提出了超节点(SuperPod)概念,并推出了 DGX SuperPOD 产品。通过将多个 DGX 系统整合到一个液冷机柜中,实现了更高的密度和效率。

开放标准的兴起

面对英伟达 NVLink 技术的大规模应用,由 AMD、英特尔、谷歌、微软、Meta、HPE、思科和博通等行业巨头联合推动的开放行业标准 UALink 等应运而生。这些标准旨在打破专有技术的生态锁定,为 AI 算力产业带来更多竞争和创新。

云服务商的需求

亚马逊、微软、谷歌、腾讯、阿里、字节等超大规模云服务商需要更高效的算力架构来支持其 AI 服务。超节点技术能够显著提升资源利用率,降低运营成本,因此受到了广泛关注。

二、什么是超节点?

2.1 超节点的定义

超节点(SuperPod)是一种新型的高性能计算架构,它通过以下方式实现算力的突破性提升:

高密度整合:将大量计算、存储、网络资源整合到一个物理单元中

统一内存空间:通过高速互联技术实现内存的统一编址和访问

超低延迟互联:采用专用高速总线,实现纳秒级的通信延迟

智能调度:通过软件定义的方式实现资源的动态分配和优化

简单来说,超节点就像是一个 "超级计算机集群的集群",它将多个计算节点整合为一个逻辑上的单一计算单元。

2.2 超节点的核心特征

1. 物理整合度高

超节点通常采用高密度机柜设计,将数十甚至数百个计算节点整合到一个或几个机柜中。例如,英伟达的 DGX SuperPOD 可以将 36 个 Grace CPU 和 72 个 Blackwell GPU 集成到一个液冷机柜中。

2. 统一内存架构

超节点实现了全局内存的统一编址,使得不同节点的内存可以像本地内存一样被访问。这消除了传统集群中 "序列化 - 网络传输 - 反序列化" 的开销。

3. 专用高速互联

超节点采用专用的高速互联技术,如 NVLink、UALink 等,实现节点间的超低延迟通信。通信延迟通常在百纳秒级别,远低于传统以太网的微秒级别。

4. 全液冷散热

由于密度极高,超节点必须采用高效的散热方案。全液冷技术能够将 PUE(电源使用效率)降低到 1.05 以下,远优于传统的风冷方案。

5. 软件定义管理

超节点配备了专门的管理软件,能够实现资源的动态分配、负载均衡、故障恢复等功能。这些软件通常基于 Kubernetes 等容器编排平台进行扩展。

2.3

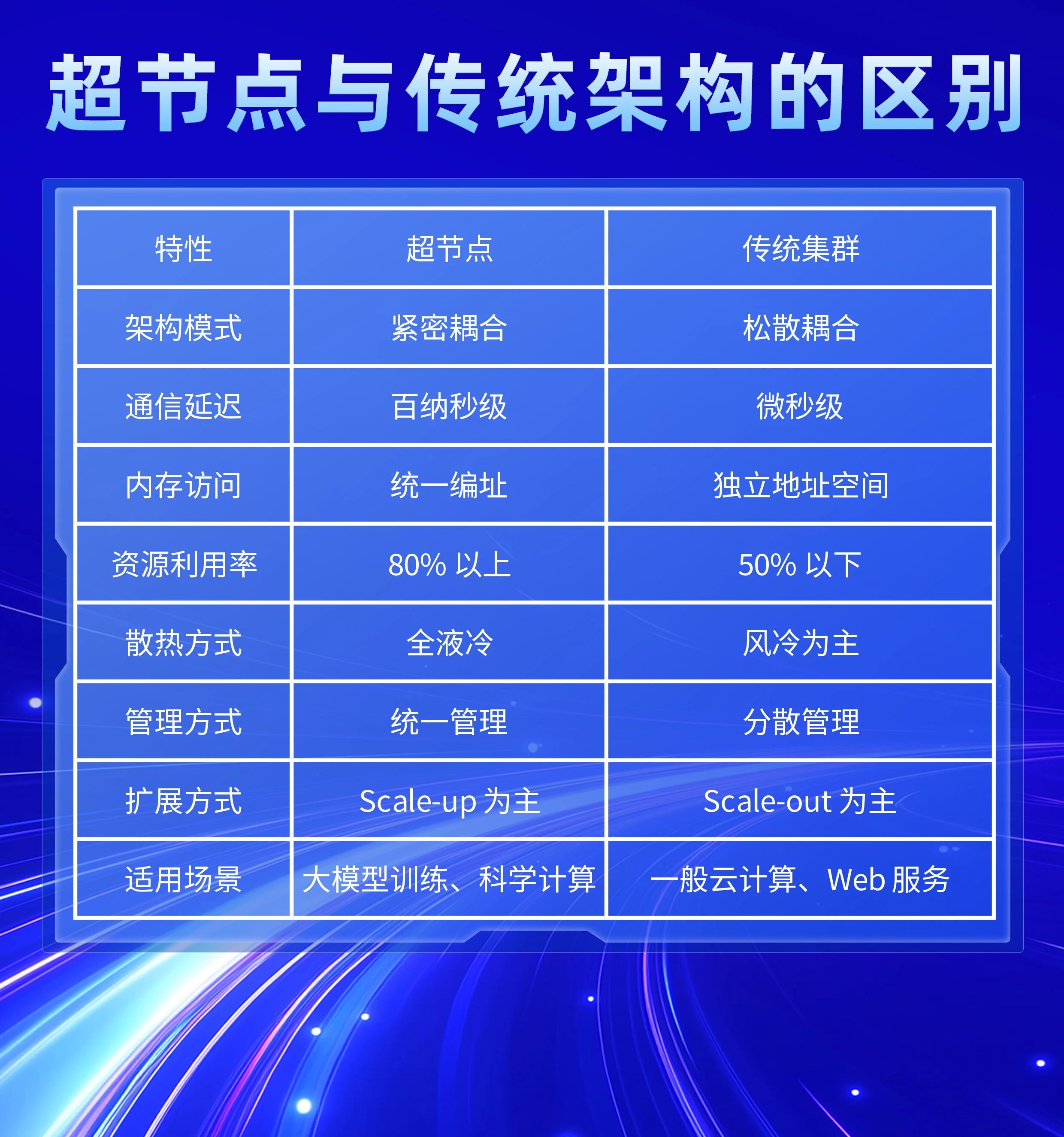

超节点与传统架构的区别

三、结语

超节点技术的出现,标志着算力架构从 "积木式堆叠" 向 "有机生命体" 的质变。在人工智能加速发展的今天,超节点不仅解决了当前的算力瓶颈问题,更为未来的通用人工智能(AGI)时代奠定了坚实的基础设施底座。

免责声明:本文内容仅供科普参考,不构成任何投资建议。文档部分内容可能由 AI 生成。技术发展存在不确定性,请读者理解。

点击“https://mp.weixin.qq.com/s/PLfKqcZGLrER6qbjAAVpKg”进入官网

ODCC秘书处联系人

刘老师:13488889649 邮箱:liupengyun@caict.ac.cn