三星豆坤:打破内存墙限制,释放存储的可扩展性

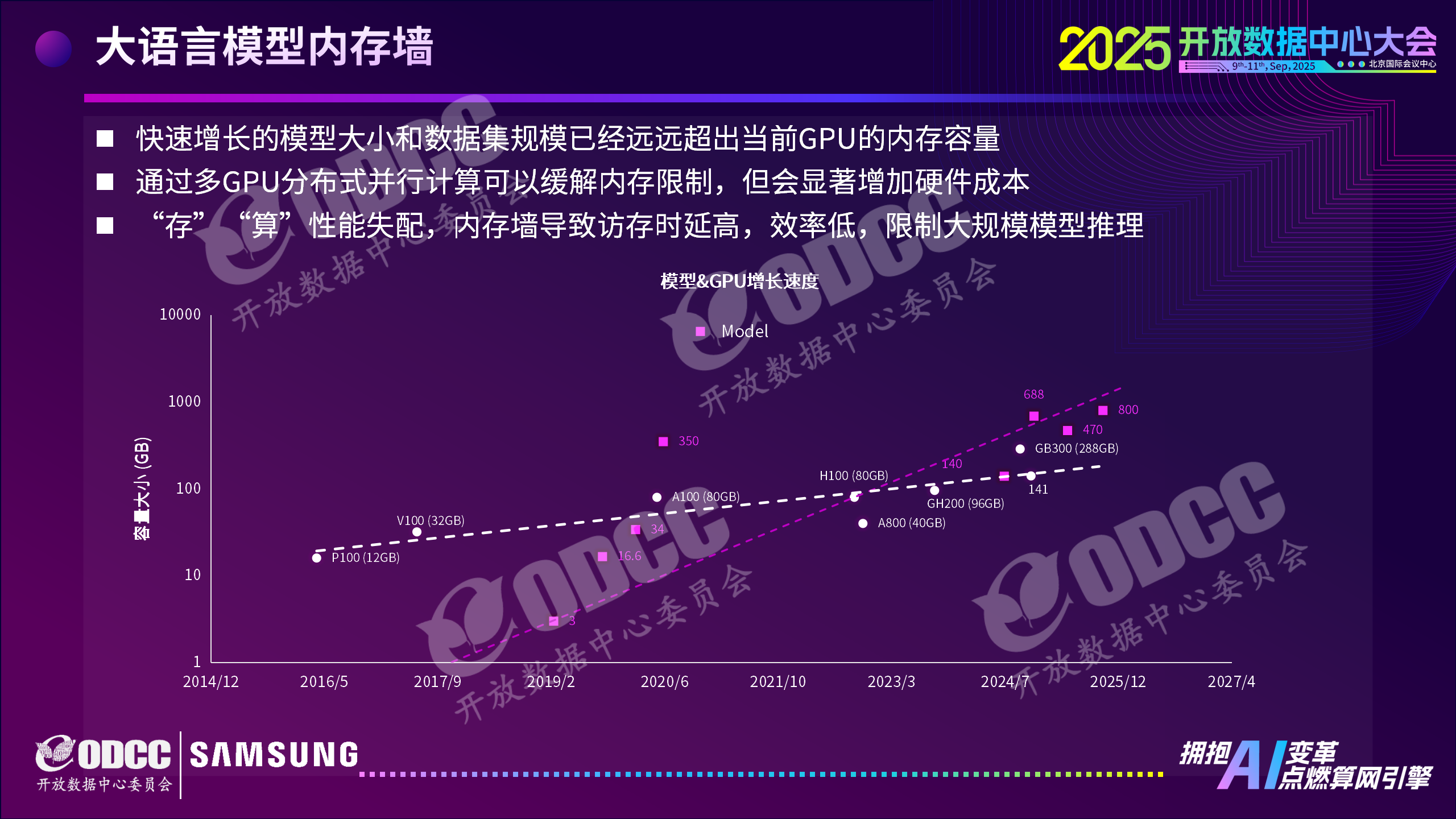

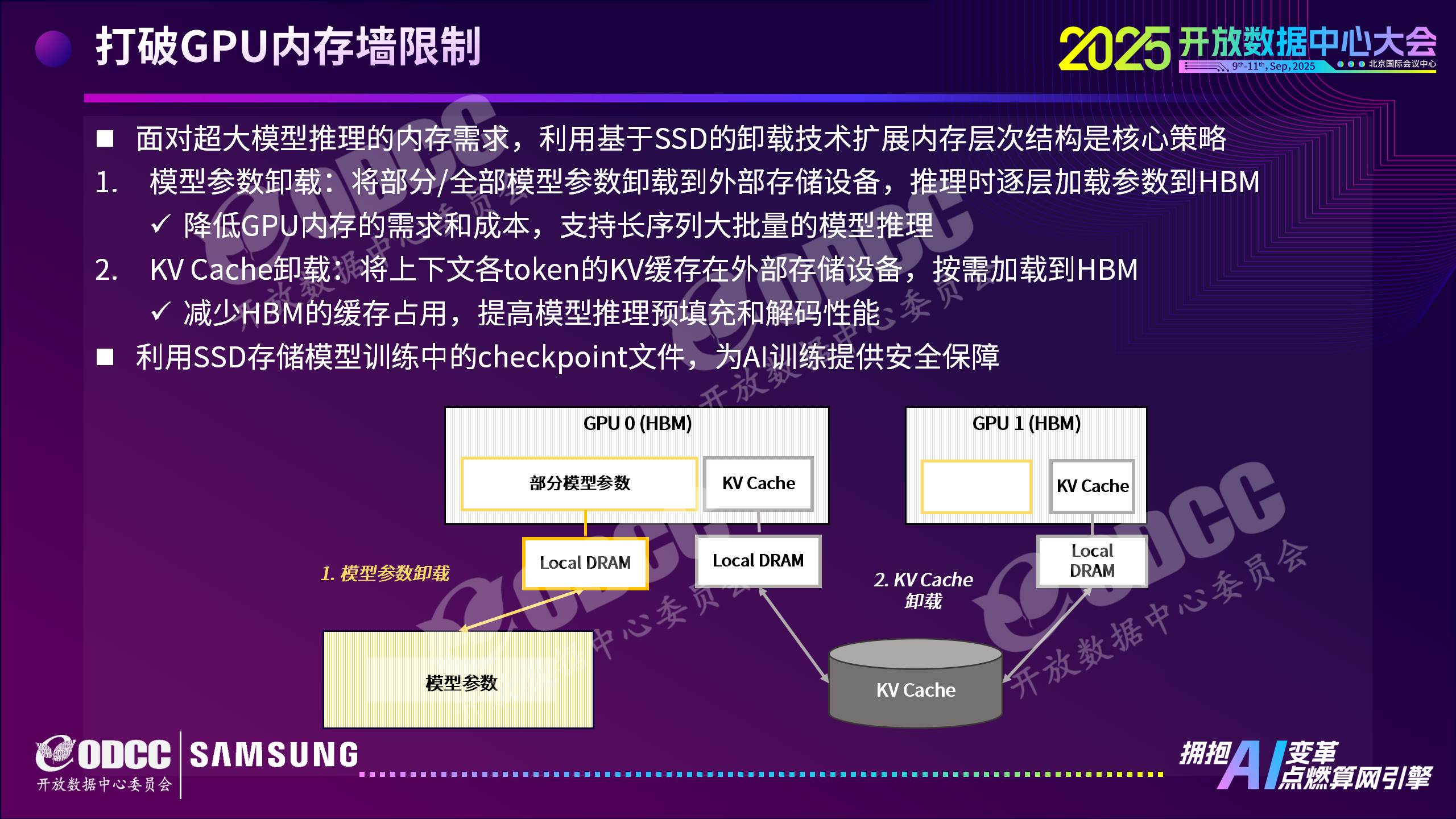

近日,2025开放数据中心大会之新技术与测试(存储)分论坛顺利召开。三星电子高级项目经理豆坤发表主题演讲,针对大语言模型(LLM)发展中面临的“内存墙”难题,提出基于SSD的存储卸载技术方案,为AI模型高效运行提供新路径。当前,LLM模型参数与数据集规模激增,远超GPU内存容量,多GPU分布式计算虽能缓解却大幅增加成本,“存算”性能失配成为制约大规模模型推理的关键瓶颈。

豆坤

三星电子高级项目经理

模型参数卸载:单GPU运行超大规模模型

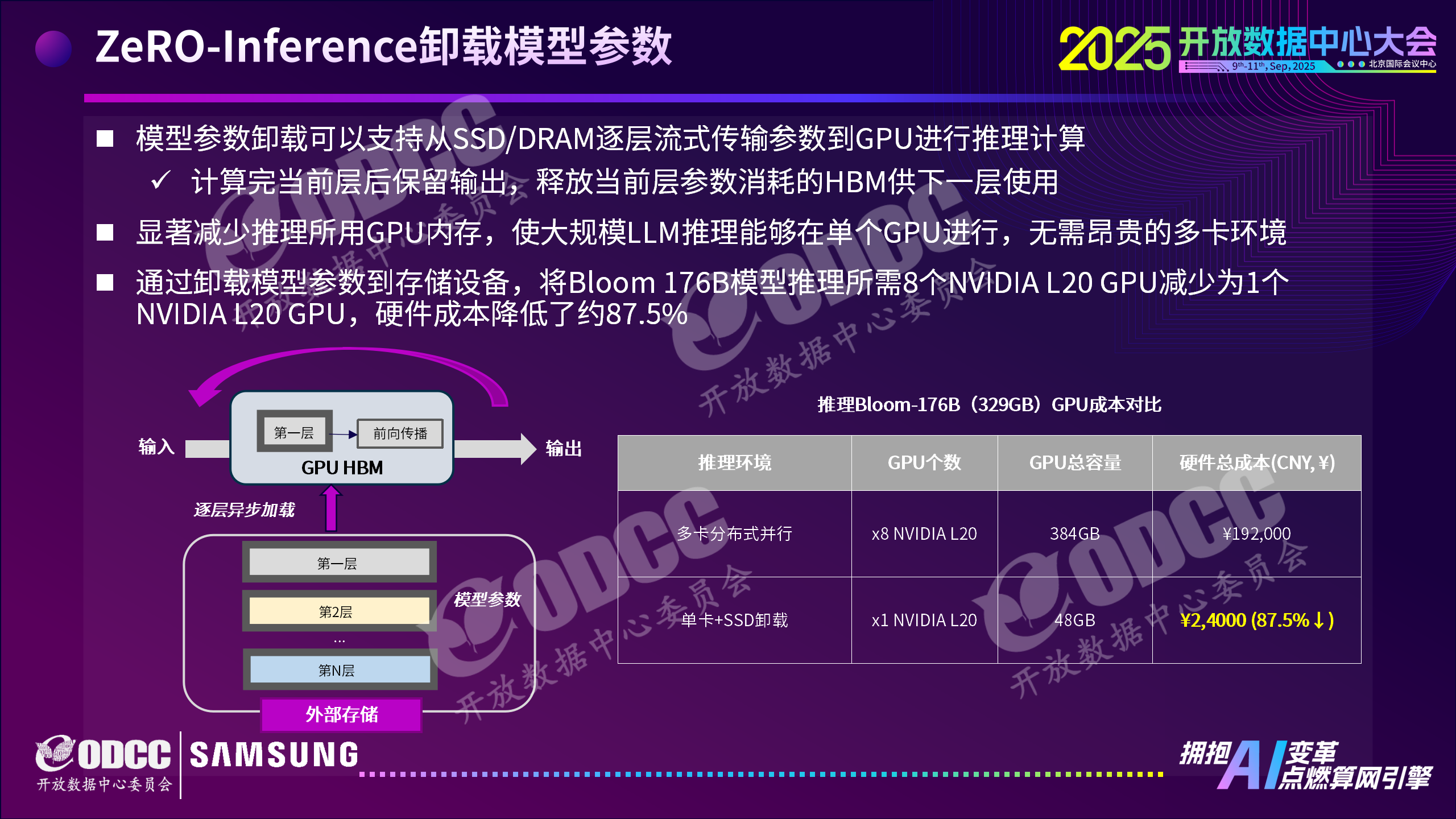

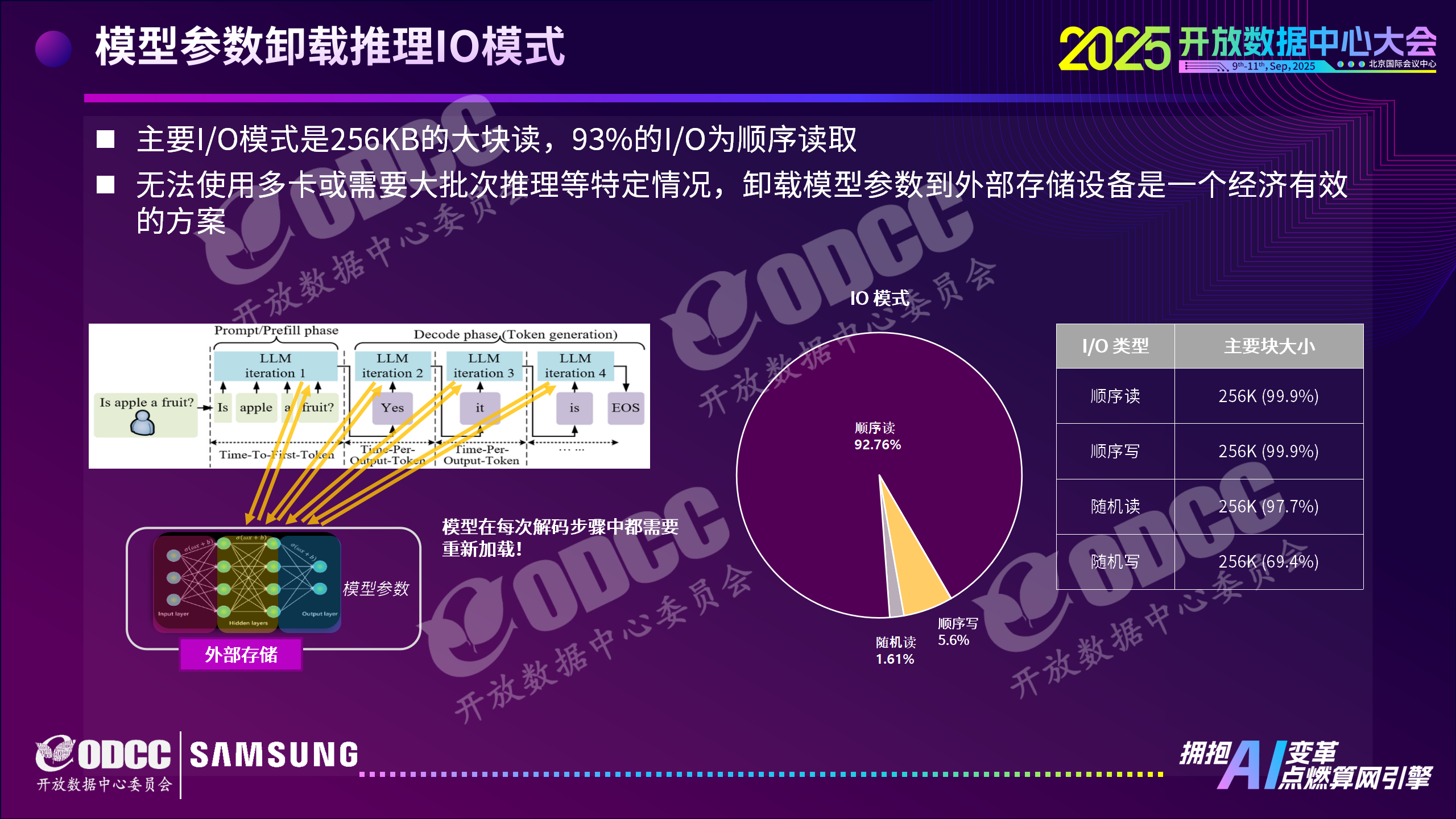

三星采用模型参数卸载技术,可将部分或全部模型参数卸载至SSD,推理时逐层流式传输到GPU。该方案让Bloom-176B模型推理所需GPU数量从8个减少至1个,硬件成本降低87.5%。其工作流程包含创建SWP文件、加载模型参数、预填充与解码三阶段,主要采用256KB大块读模式,93%的I/O为顺序读取,在无法使用多卡或需大批次推理场景中,成为经济高效的选择。

KV Cache卸载:显著提升推理速度

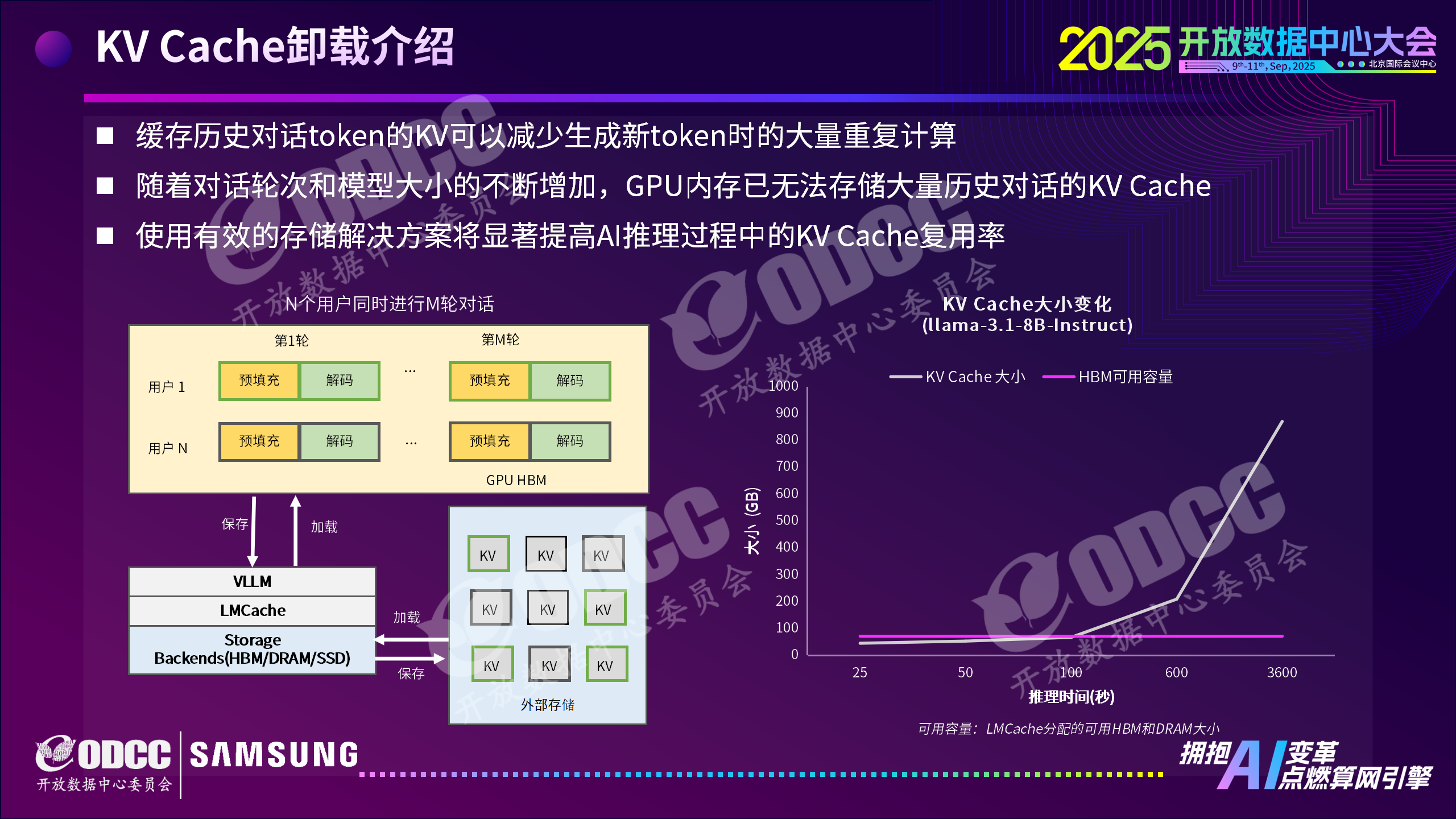

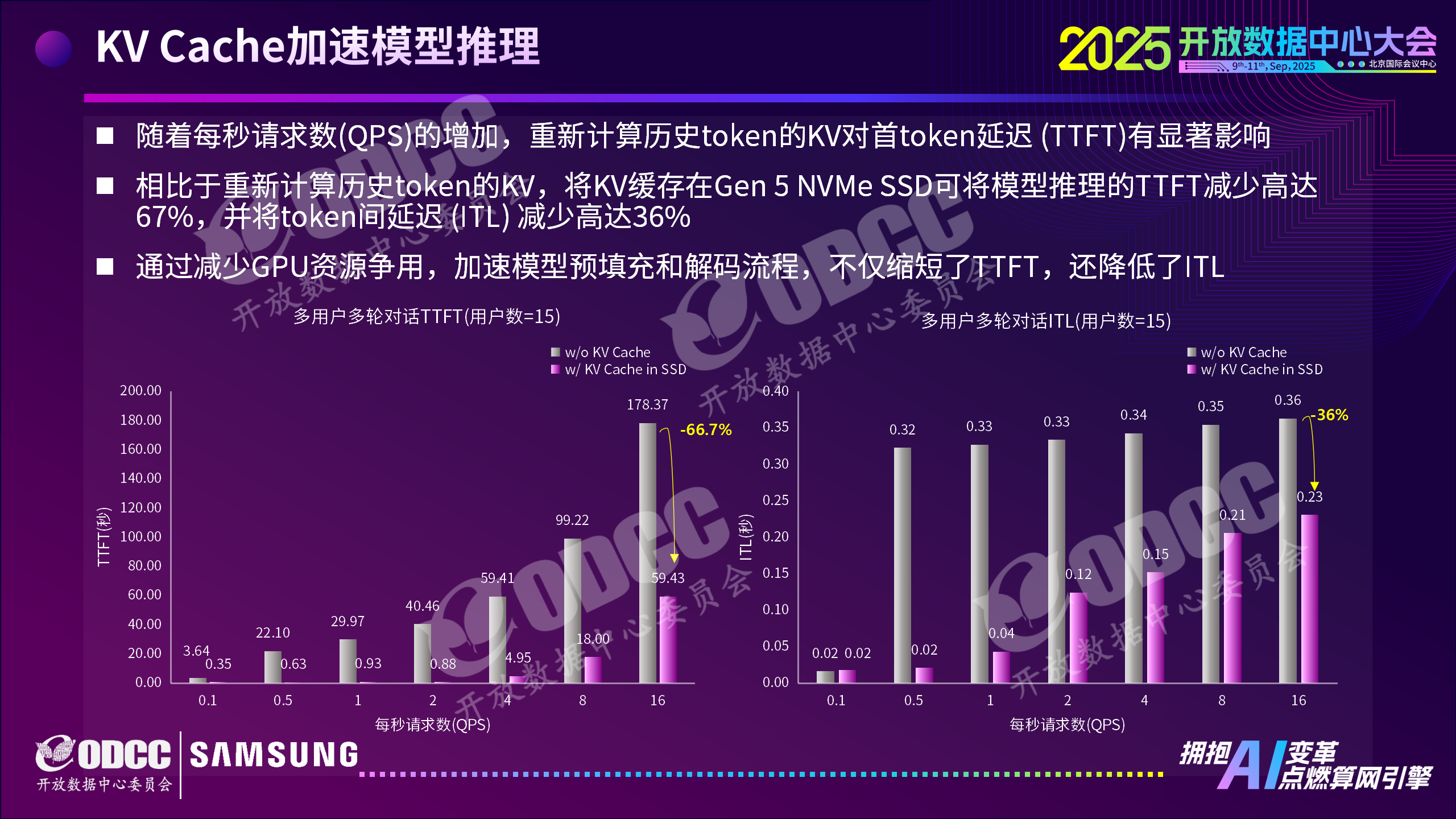

针对对话轮次增加导致GPU内存无法存储KV Cache的问题,三星将KV Cache卸载至NVMe SSD。当KV Cache大小超过HBM或DRAM容量时,该方案可使首token延迟(TTFT)最高降低66%,token间延迟(ITL)最高降低42%,且支持多用户多轮对话场景下的KV Cache重用,随着用户与对话轮次增加,I/O吞吐量稳步上升,主要I/O模式为256KB读写。

Checkpoint优化:加速Checkpoint写入,缩短AI训练时间

三星采用FastPersist技术,通过高性能I/O库与双缓冲区重叠传输,优化Checkpoint写入性能。在DeepSeek-7B模型测试中,模型权重、优化器状态保存平均吞吐量分别是传统方法的4.3倍、10.3倍,总训练时间减少66.6%,其SSD峰值带宽达8.8GB/s,99.9%的I/O为256KB顺序写,充分发挥高性能SSD优势。

三星此次展示的SSD存储卸载方案,为大语言模型突破内存限制提供切实路径,未来有望推动AI在更多场景实现高效、低成本部署,为数据中心AI应用发展注入新动力。

ODCC秘书处联系人

刘老师 13488889649(微信同号) 邮箱:liupengyun@caict.ac.cn