[25'ODCC成果]AI超节点内存池化

随着大模型训练与推理需求的迅猛增长,智算基础设施正迎来全面升级。在此背景下,AI超节点凭借新型Scale-up互联技术构建大规模高带宽域,有效提升大模型训推性能。作为AI超节点的关键技术之一,内存池化技术旨在变革内存资源使用范式,推动内存调度从“单节点本地显存独立调度”迈向“跨节点、跨介质的统一池化调度”的升级跃迁。这一变革不仅能提高超节点的资源利用效率、优化设备成本结构,更将加速AI超节点向规模化、标准化方向演进。

《AI超节点内存池化技术白皮书》立足AI大模型的演进趋势,深入剖析了内存技术挑战,系统性阐述AI超节点内存池化的定义、架构与关键技术,全面梳理了当前主流方案的技术路径与适配场景,提出了面向未来池化技术演进的两大战略方向。最后,从标准建设、接口统一、生态协同等维度提出了加快AI超节点内存池化技术落地的战略建议。白皮书将于2025开放数据中心大会上正式发布!敬请期待!

1. 提出AI超节点内存池化技术的内涵与目标

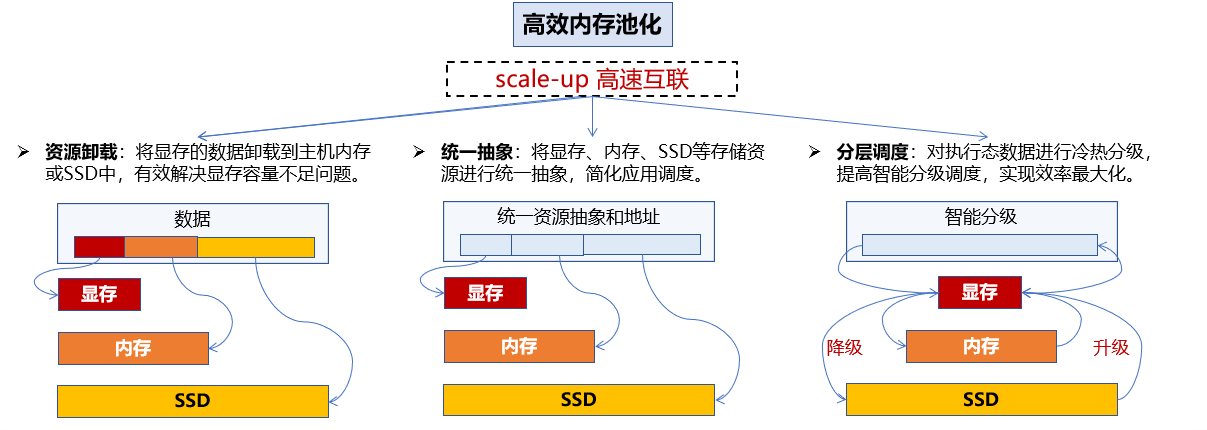

白皮书提出AI超节点内存池化是基于高性能互联网络,以资源卸载、统一抽象、分层调度为核心,实现异构内存资源的集中管理与弹性调用,旨在打破节点内和节点间的资源边界,实现“化零为整、转静为动、弹性可扩、异构协同”,提升AI模型的运行效率、系统资源利用率及硬件适配能力。

2. 梳理主流内存池化技术方案与适配场景

白皮书详细分析了ZeRO-Offload、mooncake store等五类典型内存池化方案,聚焦模型训练、推理、KVCache管理等关键场景,深入探究方案在实际应用中的成效以及面临的问题。同时,全面总结了各类方案在存储层级整合、传输路径优化、地址空间统一等方面所采用的技术思路与积累的实践经验。

3. 全面构建四层内存池化技术架构体系

白皮书构建了“硬件资源互联、内存池化管理、智能分层引擎、统一API接口”的四层池化技术架构体系。该体系覆盖全链路关键能力,包括物理资源整合、寻址空间统一、冷热数据动态迁移、跨节点分层调度、应用透明接入等,为未来AI基础设施的规模化部署与弹性扩展提供有力支撑。

4. 前瞻性规划未来池化演进的两个核心方向。

在超节点主机层面,以跨层级资源调度为核心,构建冷热智能识别、按需迁移、精细调度的分层管理体系;在超节点芯片层面,探索基于Chiplet互联与缓存一致性C2C协议的CPU-GPU共享内存架构,推动内存池化向硬件原生协同演进。

本成果将于今年9月的开放数据中心大会上正式发布!

王军良

中国电信研究院云网融合技术研究所内存架构专家

ODCC网络工作组联系人

孙老师 15732071244 邮箱:suncong@caict.ac.cn

ODCC秘书处联系人

刘老师 13488889649(微信同号) 邮箱:liupengyun@caict.ac.cn