面向DeepSeek,探索BigSwitch的业务收益最大化

在2025开放数据中心委员会(ODCC)春季全会期间,锐捷网络股份有限公司(下称 “锐捷网络”)作为ODCC成员单位,出席了网络工作组会议。

会数据中心网络解决方案经理冀国平发表了题为《面向DeepSeek架构,实现BigSwitch业务收益最大化》的分享。冀国平基于不同组网规模以及多样化服务器场景,对BigSwitch多种网络架构进行单端口归一化成本对比分析。通过数据分析与专业的技术评估,提出成本最优的网络架构方案,为数据中心网络建设与优化提供了极具价值的参考策略。

今年初DeepSeek横空出世,凭借技术架构革新、算法创新及软硬件优化,在实现显著成本降低的同时保持卓越性能,吸引众多科技巨头纷纷接入。DeepSeek通过专家混合(MoE)、FP8低精度训练、多头潜在注意力(MLA)以及流水线策略等技术,大幅提升模型训练和推理效率,成为行业广泛青睐的AI模型。。随着DeepSeek进入规模化应用阶段,基于BigSwitch探寻网络成本最优化路径成为关键议题。

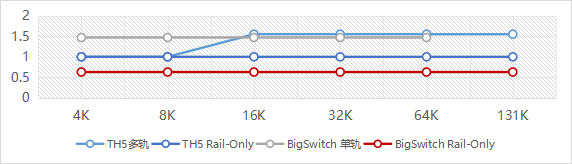

当前,AI 组网成本的核心瓶颈集中于两大因素:一是光模块成本高企,二是三级组网成本高。因此,减少光模块用量、降低网络层级成为成本优化的主要方向。在超节点算力场景下,BigSwitch根据不同组网规模的单端口归一化对比分析发现:单纯减少光模块数量的成本收益有限,而采用Rail-Only架构减少网络层级可有效减少交换机节点和光模块的数量,单端口归一化成本收益可达37%~59%。

基于DeepSeek模型特性,针对超节点算力集群Scale Up和 Scale Out的流量进行分析,旨在评估超节点算力场景采用BigSwitch Rail-Only网络架构的可行性。

模型训练流量分析

以2K规模的H800 GPU集群分布式训练为例,DeepSeek在分布式并行策略的设计上呈现差异化特点:针对非MoE层,采用PP16与DP128的分布式策略;针对MoE层,则采用PP16、DP2与EP64的混合并行策略。由于集群内大部分GPU之间的通信行为具有同构性,且每次迭代过程中的通信与计算行为具备重复性,因此可通过计算单GPU单次迭代的通信流量,构建能够描述整个训练过程的流量模型。

1.EP并行:在MoE模型中,每个MoE层的前向和反向计算都要进行一次dispatch通信和一次combine通信,操作执行的都是all to all的集合通信原语;

2.PP并行:在模型训练的前向和反向过程中,各需要一次PP通信,PP采用的通信原语是P2P;

3.DP通信采用的是all reduce原语,在采用Ring算法时, all reduce会被拆解为ReduceScatter和AllGather操作,其操作通信量大小与DP域的大小有关;

4.三种通信的流量占比为EP:PP:DP≈241:5:1。

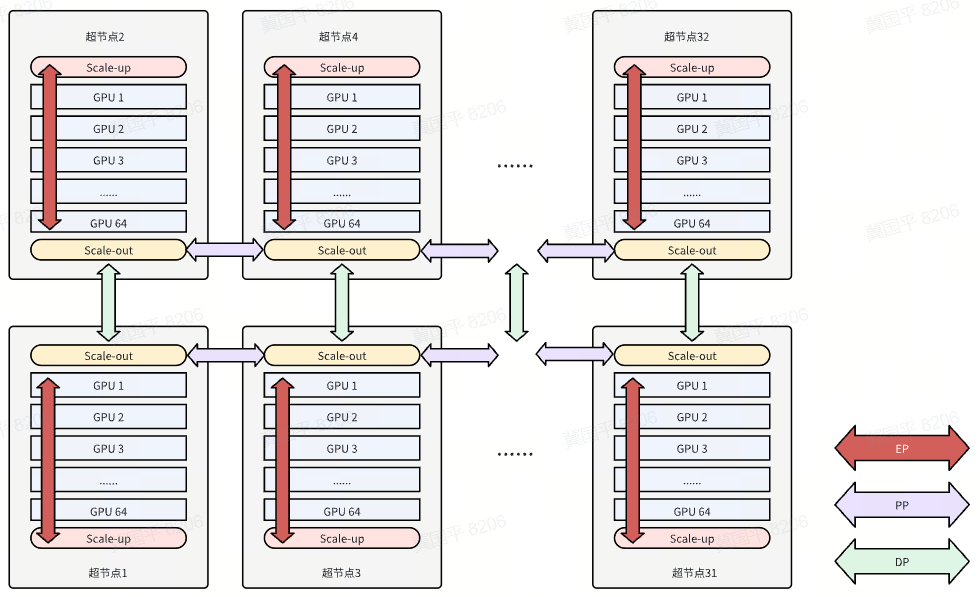

下图展示以超节点模型训练的分布式部署情况:

其中DeepSeek分布式训练策略PP=16.EP=64.DP=2.

当Scale-Up域增大时,EP通信域可自然约束在单个超节点内,使每个超节点形成独立的EP全连接通信域。由于训练过程中97%以上的流量为EP流量,且通过Scale-Up域完成通信,因此能显著提升整体通信性能。

在跨超节点通信场景中,上下相邻2个超节点的同号卡间执行DP通信,横向相邻16个超节点的同号卡间执行PP通信。由于节点间的PP和DP通信均仅发生在同号卡之间,且Scale-Out流量仅存在于同号卡通信场景,因此BigSwitch Rail-Only网络架构在超节点算力场景下具备可行性。

模型推理流量分析

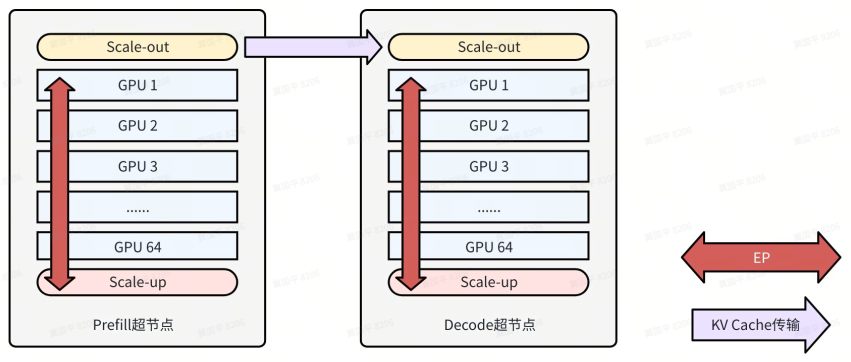

在推理阶段,DeepSeek采用了PD分离的分布式推理方案。为将EP流量约束在超节点内能够最大化通信效率,在64卡超节点场景下,需将单机柜设为Prefill和Decode最小部署单元,并采用DP64和EP64的分布式并行策略。该场景下推理过程的流量如下表:

1. Prefill EP流量

EP通信的流量计算公式同训练,但是Prefill场景下具体的数值存在一定差异。由于推理过程不涉及反向计算,每个MoE层上,都仅存在前向计算的一次dispatch和一次combine。

2. Decode EP流量

Decode流量算法等同于Prefill,一个用户只会产生一次prefill迭代,但是单个用户完成请求需要多次decode迭代,因此decode阶段虽然单次迭代流量少,但总迭代次数更多,导致总流量高于Prefill阶段。

在上述的分布式并行策略和超节点部署方案中,Prefill和Decode流量均会被约束在单个柜内,Prefill和Decode节点之间的KV Cache流量通过超节点的scale-ou网络通信,实现低时延传输,确保推理过程的高效性与稳定性。

总结

在超节点算力场景中,基于DeepSeek框架采用BigSwitch Rail-Only组网,可最大化网络成本收益。通过合理配置分布式训练的并行策略,充分释放超节点Scale UP的大带宽优势,实现Scale Up与Scale Out流量的优化,进而提升超节点算力性能。

以太网超节点互联项目作为ODCC网络工作组的关键项目之一,由中国信通院、腾讯联合交换机厂商等多家合作伙伴共同推进。项目组秉持开放创新原则,加速先进网络技术在算力中心领域的创新实践与应用落地。

联系人

锐捷网络 冀老师 18600548206

信 通 院 孙老师 15732071244

ODCC秘书处

刘老师 13488889649(微信同号) 邮箱:liupengyun@caict.ac.cn