ODCC成果回顾:《AI 数据中心网络建网参考报告》

开放数据中心委员会(ODCC)发布《AI 数据中心网络建网参考报告》,为人工智能(AI)数据中心网络建设提供了全面且权威的指导,标志着我国在 AI 数据中心网络建设领域迈出了关键一步。

随着 ChatGPT 等生成式人工智能应用的爆发式增长,AI 技术进入了大模型时代,模型参数规模从千万级增长到万亿级,对算力和数据的需求呈指数级上升。AI 的发展由算法、算力和数据三个核心要素驱动,其中算力和数据的高效传输与处理离不开强大的网络支持。然而,当前 AI 大模型训练面临诸多挑战,包括超大容量网络需求、高昂的处理器成本以及长训练周期下的网络可靠性问题。

报告指出,AI 大模型并行计算模式催生了超大容量网络需求。例如,张量并行(TP)的通信量可达数据并行(DP)和流水线并行(PP)的 50 倍。此外,AI 处理器成本高昂,要求网络减少通信时间,提升有效算力。传统的 ECMP 流量均衡机制在 AI 场景下会导致流量不均和拥塞问题。同时,AI 大模型训练周期长,需要高可用、健壮的网络来降低平均无故障时间(MTBF)。

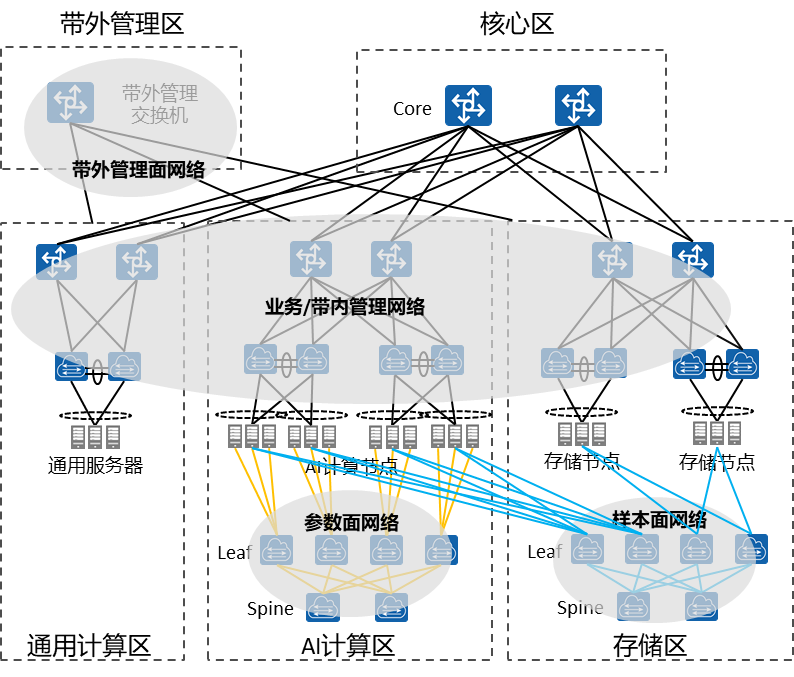

报告提出了 AI 数据中心网络的总体架构,包括逻辑架构和物理架构。逻辑架构将网络划分为接入区、管理区、业务区等不同区块,通过核心交换机连接,实现不同业务流量的隔离和保护。物理架构则详细描述了参数面、样本面、业务面和管理面网络的设计要求。其中,参数面网络采用 CLOS/Fat-tree 组网,要求无收敛组网以支持高带宽无损传输;样本面网络则需支持大带宽存储互联,确保训练数据的高效加载。

为应对上述挑战,报告提出了多项技术创新和优化方向。如在通信效率方面,提出了逐流负载均衡技术和逐包负载均衡技术,以解决传统 ECMP 机制下的流量不均问题。在高可用性方面,通过拓扑优化、光链路检测和性能可视技术,提升网络的可靠性和运维效率。此外,报告还强调了超融合以太网络的重要性,指出其在支持大规模 AI 网络方面需在流控和拥塞控制方面进行创新。

报告分享了互联网、运营商和金融行业的 AI 数据中心网络建设案例。如科大讯飞采用华为星河 AI 数据中心网络解决方案,建成了高速万卡超大规模智算集群,有效保障了星火认知大模型的快速演进。中国移动则建设了全球运营商最大单体智算中心,采用端到端自主可用的 AI 网络设备,满足了从千卡到万卡的平滑演进需求。工商银行则率先构建了千亿级 AI 大模型数据中心基础设施,实现了全栈自主可控和智能无损网络支撑,显著提升了 AI 模型训练效率和算力资源利用率。

《AI 数据中心网络建网参考报告》的发布,为 AI 数据中心网络建设提供了明确的技术方向和实践指南,为行业企业提供了宝贵的参考,同时为我国在全球人工智能竞争中占据领先地位奠定了基础。开放数据中心委员会(ODCC)将继续携手行业伙伴,深入研究和探索 AI 数据中心网络技术,推动相关技术的落地和验证,助力我国算力产业的高质量发展。

点击https://mp.weixin.qq.com/s/sl8flivqKmfUcni_76xpKQ,下载文档

新技术与测试工作组联系人

李老师:19528282160 邮箱:lijiayuan@caict.ac.cn

ODCC秘书处

刘老师 13488889649(微信同号) 邮箱:liupengyun@caict.ac.cn