ODCC成果回顾:《基于DPU的高性能存储网络技术报告》

《基于DPU的高性能存储网络技术报告》在2024年ODCC开放数据中心大会上正式发布。报告围绕DPU的高性能存储网络技术展开,从架构、技术、应用到挑战与展望,全面剖析了该技术在数据中心领域的关键要素与发展脉络,为数据中心领域的技术创新与产业发展提供重要的理论支持与实践指导。

在数字经济迅猛发展的时代浪潮下,算力已然跃升为核心生产力,数据中心的重要性愈发凸显,成为支撑数字经济发展的关键基础设施。然而,传统的存算融合架构暴露出一系列亟待解决的问题,例如资源扩展缺乏灵活性,难以快速响应业务的动态变化;资源利用率较低,造成了大量的资源闲置与浪费。在此背景下,存算分离架构应运而生,为解决上述难题提供了新的思路与方向。

在存算分离架构的实践应用中,基于非易失性存储介质的NVMe-oF协议得到了广泛采用。该协议凭借其在数据传输速度和存储效率方面的显著优势,为存算分离架构的运行提供了有力支持。然而,由于受到CPU性能的限制,协议在实际应用过程中衍生出了“数据中心税”问题,不仅增加了数据中心的运营成本,还在一定程度上制约了存算分离架构优势的充分发挥,亟待行业各方共同探索解决方案。

DPU高性能存储网络技术

DPU以数据为中心,运用软件定义技术,分离主机侧CPU的网络存储协议,降低CPU占用率,提高处理效率。RDMA网络是高性能数据传输的关键,具备内核旁路、零拷贝及CPU卸载特性,可直接读写远程服务器内存数据。其中,InfiniBand和RoCEv2方案应用广泛,RoCE技术能在以太网上承载 IB 协议,RoCEv2 可部署于三层网络,提升利用率。

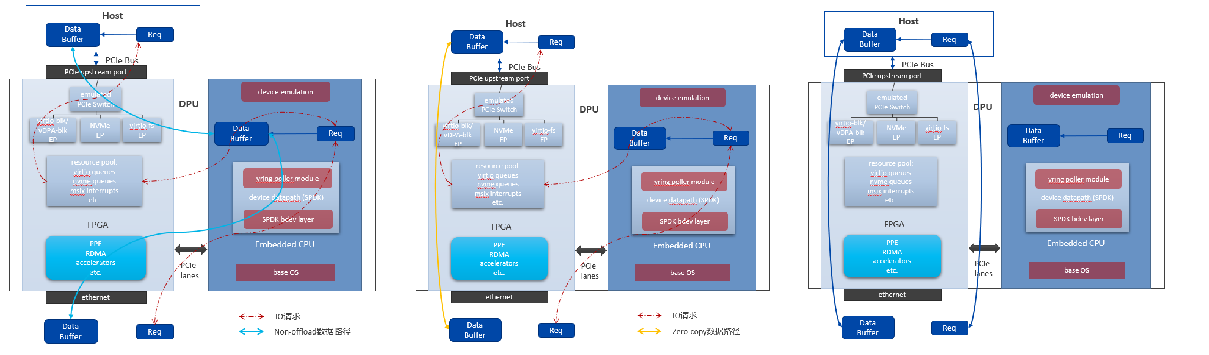

NVMe over Fabric基于NVMe协议,支持多队列与高并发,适配TCP、RDMA与FC等多种网络协议,提高数据处理能力。DPU技术范畴广泛,其中涵盖了IO硬件设备虚拟化等关键领域。在NVMe over RDMA 协议应用场景下,针对NVMe/virtio-blk设备虚拟化卸载,存在Non-offload、Zero-Copy和Full-offload三种模式,满足不同应用场景下多样化需求。

在数据中心基础架构中,DPU通过卸载高性能存储网络功能,在裸金属与虚拟化场景中展现出差异化技术价值。在裸金属服务器场景中,DPU创新性地实现存储资源远程本地化访问。通过硬件加速技术绕过传统多层协议栈的处理瓶颈,有效规避网络协议栈处理带来的性能衰减,使裸金属服务器能够以近似本地存储的性能直接访问远端存储资源,达成存储资源解耦与性能无损的平衡。在虚拟化服务器场景中,DPU通过智能资源虚拟化技术重构存储访问路径。依托零拷贝传输机制和硬件级虚拟化支持,有效减少内存拷贝操作及虚拟化软件层带来的额外开销,使得虚拟机对网络存储的读写性能损耗逼近物理极限,显著提升虚拟化环境下的存储I/O效率。

展望未来,随着存算分离架构的广泛应用,基于DPU的存储卸载方案将成为智能计算中心的核心技术支撑。该方案不仅为无损网络接入和分布式存储提供了高效解决方案,还将进一步推动数据中心领域的技术创新,助力数字经济发展。

点击https://mp.weixin.qq.com/s/rBJwMnd4eKXG-4URGWdEhg ,下载文档

网络工作组联系人

孙老师:15732071244

邮箱:suncong@caict.ac.cn

ODCC秘书处

刘老师 13488889649(微信同号)

邮箱:liupengyun@caict.ac.cn